NVIDIA GeForce RTX 3090 Ti análisis

NVIDIA GeForce RTX 3090 Ti análisis. Durante los últimos dos años hemos analizado casi todas las tarjetas gráficas de la familia GeForce RTX 30 que NVIDIA ha colocado en el mercado. Sin embargo, ninguna de esas propuestas es tan ambiciosa como la solución gráfica que estamos a punto de poner a prueba en este análisis. Tenemos pistas sólidas que nos invitan a prever que la serie GeForce RTX 40 está cerca, pero por el momento esta GeForce RTX 3090 Ti es indiscutiblemente el modelo insignia de esta marca. Si tienes alguna inquietud recuerda contactarnos a través de nuestras redes sociales, o regístrate y déjanos un comentario en esta página. También puedes participar en el WhatsApp. Si usas Telegram ingresa al siguiente enlace.

En la tabla de especificaciones que publicamos debajo de estas líneas podemos ver que la RTX 3090 Ti incorpora más núcleos CUDA, más unidades RT, y también más núcleos Tensor que la GeForce RTX 3090. Sobre el papel el músculo de esta tarjeta gráfica impresiona, pero su principal seña de identidad, lo que la desmarca de cualquier otra solución gráfica, es que incorpora 24 GB de memoria de vídeo de tipo GDDR6X. Nada menos que el doble de VRAM de la GeForce RTX 3080 Ti. Así se las gasta este monstruo gráfico.

NVIDIA GeForce RTX 3090 Ti: especificaciones técnicas

NVIDIA GEFORCE RTX 3090 TI

GEFORCE RTX 3090

NVIDIA GEFORCE RTX 3080 TI

NVIDIA GEFORCE RTX 3080

ARQUITECTURA

Ampere

Ampere

TRANSISTORES

28 300 millones

millones

28 300 millones

28 000 millones

FOTOLITOGRAFÍA

8 nm Samsung (tecnología de integración personalizada para NVIDIA)

nm Samsung (tecnología de integración personalizada para NVIDIA)

8 nm Samsung (tecnología de integración personalizada para NVIDIA)

8 nm Samsung (tecnología de integración personalizada para NVIDIA)

NÚCLEOS CUDA

10 752

10 240

8704

NÚCLEOS RT

84 (2ª generación)

82 (2ª generación)

80 (2ª generación)

68 (2ª generación)

NÚCLEOS TENSOR

336 (3ª generación)

328 (3ª generación)

320 (3ª generación)

272 (3ª generación)

UNIDADES DE CÁLCULO (CU)

84

82

80

68

CACHÉ DE NIVEL 1

128 Kbytes (por SM)

Kbytes (por SM)

128 Kbytes (por SM)

128 Kbytes (por SM)

CACHÉ DE NIVEL 2

6 Mbytes

Mbytes

6 Mbytes

5 Mbytes

FRECUENCIA DE RELOJ MÁXIMA

1,86 GHz

1,70 GHz

1,67 GHz

1,71 GHz

MEMORIA DEDICADA

24 GB GDDR6X

24 GB GDDR6X

12 GB GDDR6X

10 GB GDDR6X

BUS DE MEMORIA

384 bits

bits

384 bits

320 bits

VELOCIDAD DE TRANSFERENCIA DE LA MEMORIA

1008 GB/s

936,2 GB/s

912 GB/s

760 GB/s

SHADER TFLOPS (FP32)

40

36

34

29,77

TENSOR FLOPS

320

285

273

238

OPERACIONES DE RASTERIZACIÓN

112 ROP/s

ROP/s

112 ROP/s

96 ROP/s

UNIDADES DE MAPAS DE TEXTURAS

336

328

320

272

TASA DE TEXTURAS

625 Gtexeles/s

556 Gtexeles/s

532,8 Gtexeles/s

465 Gtexeles/s

TASA DE PÍXELES

208,3 Gpíxeles/s

189,8 Gpíxeles/s

186,5 Gpíxeles/s

164 Gpíxeles/s

DIRECTX 12 ULTIMATE

Sí

Sí

INTERFAZ PCI EXPRESS

PCIe 4.0

PCIe 4.0

REVISIÓN HDMI

2.1

2.1

REVISIÓN DISPLAYPORT

1.4a

1.4a

DLSS 2

Sí

Sí

RANURAS OCUPADAS

3

3

2

2

TEMPERATURA MÁXIMA DE LA GPU

92 ºC

ºC

93 ºC

93 ºC

CONSUMO MEDIO

450 vatios

350 vatios

350 vatios

320 vatios

POTENCIA RECOMENDADA PARA LA FUENTE DE ALIMENTACIÓN

850 vatios

750 vatios

vatios

750 vatios

CONECTORES DE ALIMENTACIÓN

3 x 8 pines

2 x 8 pines

x 8 pines

2 x 8 pines

PRECIO

1576,84 euros

1563,33 euros

1563,76 euros

899,89 euros

Sistema Online

Así es como las GeForce RTX 30 han conseguido superar a las RTX 20

Las tecnologías implementadas por NVIDIA en el procesador gráfico GeForce RTX 3090 Ti son idénticas a las de las GPU de la familia GeForce RTX 30 que hemos analizado hasta ahora. Estas son las mejoras más relevantes introducidas por esta compañía en la que aún hoy es su serie de soluciones gráficas más avanzada si la comparamos con su predecesora, la familia GeForce RTX 20:

Integran una cantidad de núcleos CUDA sensiblemente mayor.

Estos núcleos se responsabilizan de llevar a cabo los cálculos complejos a los que se enfrenta una GPU para resolver, entre otras tareas, la iluminación general, el sombreado, la eliminación de los bordes dentados o la física. Estos algoritmos se benefician de una arquitectura que prioriza el paralelismo masivo, por lo que cada nueva generación de procesadores gráficos de NVIDIA incorpora más núcleos CUDA.

Incorporan más núcleos RT (Ray Tracing). Estas son las unidades que se encargan expresamente de asumir una gran parte del esfuerzo de cálculo que requiere el renderizado de las imágenes mediante trazado de rayos, liberando de este estrés a otras unidades funcionales de la GPU que no son capaces de llevar a cabo este trabajo de una forma tan eficiente. Son en gran medida responsables de que las tarjetas gráficas de las series GeForce RTX 20 y 30 sean capaces de ofrecernos ray tracing en tiempo real.

También tienen unos núcleos Tensor más avanzados.

- Al igual que los núcleos RT, los núcleos Tensor son unidades funcionales de hardware especializadas en resolver operaciones matriciales que admiten una gran paralelización, pero estos últimos han sido diseñados expresamente para ejecutar de forma eficiente las operaciones que requieren los algoritmos de aprendizaje profundo y la computación de alto rendimiento. Los núcleos Tensor ejercen un rol esencial en la tecnología DLSS (Deep Learning Super Sampling) de la que hablaremos a lo largo de todo este análisis.

- Las tarjetas gráficas de la familia GeForce RTX 30 implementan la tecnología Reflex, que persigue reducir la latencia a lo largo de todo el cauce de la señal para minimizar el lapso de tiempo que se extiende desde el momento en el que damos una orden desde nuestro teclado o ratón hasta el instante en el que tiene un efecto en el monitor. Esta innovación reduce sensiblemente la latencia, especialmente cuando se incrementa la resolución. Si queréis conocerla a fondo no os perdáis el artículo en el que la analizamos.

- La nueva tecnología RTX IO permite a la GPU intervenir en la descompresión de los datos almacenados en la unidad de almacenamiento secundario para reducir los tiempos de carga y liberar a la CPU de la mayor parte del estrés impuesto por esta tarea. Los algoritmos de descompresión pueden sacar partido al paralelismo inherente de los procesadores gráficos.

- Al igual que los núcleos RT, los núcleos Tensor son unidades funcionales de hardware especializadas en resolver operaciones matriciales que admiten una gran paralelización

- La aplicación NVIDIA Broadcast recurre a la inteligencia artificial para, según sus creadores, mejorar nuestra experiencia cuando hablamos a través de una videollamada o emitimos contenido en vivo. Sus tres funciones principales son eliminar el ruido en segundo plano, recrear un fondo virtual y actuar sobre el encuadre de forma automática.

- Estas son las primeras tarjetas gráficas de NVIDIA capaces de comunicarse con los demás componentes de nuestros ordenadores a través de un enlace PCI Express 4.0. No obstante, funcionan perfectamente en una placa base con buses PCI Express 3.0. De hecho, aún no está claro el impacto que tendrá el salto a la norma 4.0 desde el punto de vista de los gráficos porque tendremos que averiguar en qué condiciones consigue saturar el subsistema gráfico un enlace PCIe 3.0. A priori la CPU tiene un impacto mucho más profundo en el rendimiento con los juegos, especialmente si buscamos las mayores cadencias de fotogramas posibles.

- El puerto HDMI de las GeForce RTX 30 implementa la norma 2.1. No cabe duda de que esta es una gran noticia porque nos va a permitir sacar más partido a nuestro PC cuando lo conectemos a un televisor de última hornada que también satisfaga esta norma. Bienvenidos sean los gráficos con resolución 4K UHD y una cadencia de imágenes variable de hasta 120 FPS (los paneles de los televisores más ambiciosos trabajan con un refresco nativo de 120 Hz).

La sobrecogedora GeForce RTX 3090 Ti Founders Edition, en detalle

La presencia física de esta tarjeta gráfica impone. La versión Founders Edition mide 313 x 138 mm y acapara tres ranuras de la caja de nuestro PC, por lo que es importante que antes de hacernos con una solución gráfica tan voluminosa nos cercioremos de que entra con cierta holgura en el interior de nuestro ordenador.

El siguiente requisito importante que merece la pena que no pasemos por alto es el consumo máximo teórico de esta GeForce RTX 3090 Ti, que, según NVIDIA, roza los 450 vatios. La fuente de alimentación que nos recomienda esta marca debe tener una capacidad de entrega de potencia de al menos 850 vatios, aunque, como es lógico, los usuarios podemos matizar esta cifra dependiendo del consumo de los demás componentes con los que esta solución gráfica va a convivir en nuestro PC, especialmente del de la CPU.

Buena parte de la superficie de la tarjeta gráfica es un disipador que aglutina numerosas láminas finas de aluminio. Su propósito es maximizar la superficie en contacto con el aire para optimizar la transferencia de energía térmica entre un medio sólido, el disipador, y un medio gaseoso, el aire, mediante convección.

El disipador de aluminio maximiza la transferencia de energía térmica hacia el aire mediante convección

El sistema de refrigeración que NVIDIA ha diseñado para estas tarjetas gráficas es muy diferente al que esta compañía nos propuso en los modelos GeForce RTX 20 Founders Edition. La refrigeración de la GeForce RTX 3090 Ti está diseñada para tomar aire a temperatura ambiental procedente del exterior del PC a través de los dos ventiladores instalados en la parte inferior de la tarjeta gráfica.

Una vez que el aire ha recogido una parte de la energía térmica que le ceden la GPU y los otros componentes de la tarjeta es expulsado hacia el exterior de la caja a través de la tobera alojada junto a los conectores DisplayPort y HDMI, así como a través del mismo ventilador de la caja que expulsa el aire caliente de la CPU.

En la siguiente fotografía de detalle podemos ver con claridad la salida de aire alojada junto a los conectores DisplayPort y HDMI. Esta tarjeta incorpora tres salidas DisplayPort ideales para instalaciones multimonitor, y, como he mencionado unos párrafos más arriba, también tiene una salida HDMI que implementa la norma y que nos permite enviar la señal de vídeo a un televisor (lo ideal es que también sea compatible con este estándar para poder sacar partido a las prestaciones vinculadas a él).

La siguiente fotografía en la que merece la pena que nos detengamos refleja de una forma rotunda la imponente presencia física que tiene esta tarjeta gráfica de NVIDIA. La solución que vemos en la parte inferior es la GeForce RTX 3090 Ti, y sobre ella hemos colocado una GeForce RTX 3080 Ti Founders Edition que por sí sola también tiene la capacidad de intimidar. Sin embargo, si la colocamos al lado de su hermana mayor su poderío físico se resiente debido a que, como podemos ver, es perceptiblemente menos voluminosa que la RTX 3090 Ti.

La arquitectura, explicada

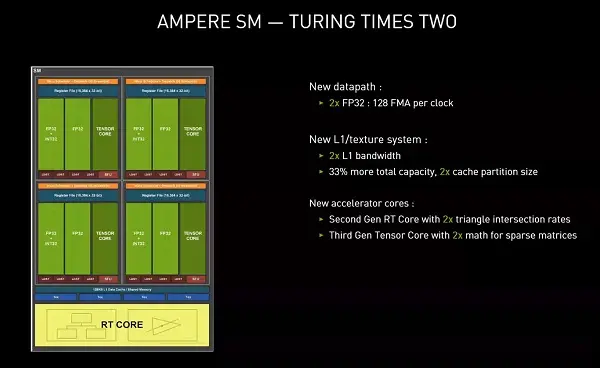

La diapositiva que publicamos debajo de estas líneas recoge algunas de las mejoras introducidas por NVIDIA en la arquitectura para permitir a las GPU que la utilizan aventajar a los procesadores gráficos con arquitectura Turing. Las GeForce RTX 30 incorporan, como hemos visto en los primeros párrafos del artículo, una mayor cantidad de núcleos RT y Tensor que los modelos equivalentes que las han precedido, pero, además, estos núcleos no son idénticos a las unidades homónimas integradas en las tarjetas GeForce RTX 20.

Los núcleos RT de 2ª generación son capaces de resolver hasta el doble de intersecciones de triángulos que las unidades de 1ª generación por unidad de tiempo. Y los núcleos Tensor de 3ª generación duplican el rendimiento de los de 2ª generación en la resolución de operaciones con las matrices dispersas que son tan habituales en los algoritmos de aprendizaje profundo.

Otra de las innovaciones interesantes que introduce la arquitectura es la aceleración por hardware del desenfoque de movimiento. La lógica que se encarga de llevar a cabo esta tarea está integrada en los núcleos RT, que, además de ser capaces de resolver más intersecciones de triángulos, en incorporan la lógica necesaria para interpolar la posición que va a tener un triángulo en varios instantes consecutivos, resolver de una forma eficiente la intersección de esos triángulos y aplicarles el filtro de desenfoque que requiere este efecto.

La optimización que los ingenieros de NVIDIA han introducido en los núcleos Tensor de 3ª generación les permite aventajar con mucha claridad a los de 2ª generación incluso cuando los primeros son inferiores en número. En la arquitectura cada SM (Stream Multiprocessor) incorpora 4 núcleos Tensor de 3ª generación, mientras que en Turing cada uno de ellos integra 8 núcleos Tensor de 2ª generación.

Sin embargo, esta presumible desventaja en número no es tal.

Y es que según NVIDIA los nuevos núcleos pueden resolver el doble de operaciones con matrices densas y el cuádruple de operaciones con matrices dispersas que los núcleos Tensor de la generación anterior.

Otra de las bazas de las tarjetas GeForce RTX 30 de gama alta que les permiten aventajar a sus predecesoras son sus chips de memoria GDDR6X. Este estándar propone una nueva señalización de cuatro niveles frente a los dos niveles de las memorias GDDR6; una nueva codificación que permite resolver las transiciones entre los cuatro niveles con más eficacia; y, por último, nuevos algoritmos para entrenamiento y adaptación.

El rendimiento del subsistema de memoria tiene un impacto profundo en las prestaciones de una tarjeta gráfica, pero, desafortunadamente, solo las GeForce RTX 3080 Ti, 3080, 3090 Ti y 3090 incorporan chips GDDR6X. Los demás modelos de la serie GeForce RTX 30 se apoyan en chips GDDR6.

Como os he anticipado unos párrafos más arriba, la tecnología RTX IO permite a la GPU encargarse de la descompresión de los datos almacenados en el subsistema de almacenamiento secundario. Según NVIDIA sus procesadores gráficos de la serie RTX 30 acometen esta tarea arrojando un rendimiento 100 veces mayor que el de una CPU de propósito general gracias a su paralelismo masivo inherente. Y, además, liberan a esta última de esta carga de trabajo.

Esta tarjeta gráfica lo da todo con juegos cuando renderiza a 2160p

La configuración del equipo que hemos utilizado para evaluar el rendimiento de esta tarjeta gráfica es la siguiente: microprocesador Intel Core i9-10900K con 10 núcleos, 20 hilos de ejecución (threads) y una frecuencia de reloj máxima de 5,30 GHz; dos módulos de memoria Corsair Dominator Platinum DDR4-3600 con una capacidad conjunta de 16 GB y una latencia de 18-19-19-39; una placa base Gigabyte Z490 AORUS Master con chipset Intel Z490; una unidad SSD Samsung 970 EVO Plus con interfaz NVMe M.2 y una capacidad de 500 GB; un sistema de refrigeración por aire para la CPU Corsair A500 con ventilador de rodamientos por levitación magnética y una fuente de alimentación modular Corsair RM 750x.

Hemos utilizado esta plataforma de pruebas porque es la misma que hemos usado durante los últimos meses para probar a fondo las tarjetas gráficas de última generación que han lanzado tanto NVIDIA como AMD. Por último, el monitor que hemos utilizado en los tests es un ROG Strix XG27UQ de ASUS equipado con un panel LCD IPS de 27 pulgadas con resolución 4K UHD y capaz de trabajar a una frecuencia de refresco máxima de 144 Hz.

Todas las pruebas las hemos ejecutado con la máxima calidad gráfica implementada en cada juego o test y habilitando la API DirectX 12 en aquellos títulos en los que está disponible. El modo DLSS que hemos seleccionado en las tarjetas gráficas de NVIDIA en aquellos juegos que implementan esta tecnología es el que prioriza el rendimiento. Y, por último, las herramientas que hemos utilizado para recoger los datos son FrameView, de NVIDIA; OCAT, de AMD; y FRAPS. Las tres están disponibles gratuitamente.

La prueba Time Spy de 3DMark ha sido durante muchos meses un feudo de la Radeon RX 6900 XT, pero su reinado ha terminado. En la siguiente gráfica podemos ver que esta tarjeta de AMD bate en este test con claridad a la GeForce RTX 3080 Ti de NVIDIA, pero la GeForce RTX 3090 Ti se impone a la Radeon con esa misma contundencia. Tenemos una nueva reina de 3DMark, y parece que no va a ser fácil destronarla. Veremos qué consigue hacer la próxima generación de soluciones gráficas en esta prueba.

En ‘Wolfenstein: Youngblood’ la GeForce RTX 3090 Ti enseña los dientes.

A 1080p las Radeon RX 6900 XT y 6800 XT son más rápidas, pero a 1440p, y, sobre todo, a 2160p, la RTX 3090 Ti se impone con claridad. De hecho, a esta última resolución aventaja con una suficiencia insultante a todas las tarjetas gráficas que hemos incluido en nuestro banco de pruebas.

En ‘Doom Eternal’ sucede algo muy interesante. A 1080p varias soluciones gráficas tanto de NVIDIA como de AMD han arrojado un rendimiento superior al de la GeForce RTX 3090 Ti, pero a 1440p esta última recorta un poco esa ventaja, y a 2160p consigue imponerse con mucha claridad. El motor gráfico de este juego refleja que, como podíamos intuir desde un principio, el renderizado a esta última resolución encaja como un guante con las capacidades de la propuesta gráfica más potente de NVIDIA.

En ‘Death Stranding’ sucede algo similar a lo que hemos observado en la prueba anterior. A 1080p las demás tarjetas gráficas rinden mejor que la RTX 3090 Ti; a 1440p recorta la distancia que la separa de las más rápidas, y, por último, a 2160p solo la GeForce RTX 3080 Ti y la RTX 3080 son más rápidas al recurrir a la tecnología DLSS. Un apunte interesante: en este juego esta tecnología de reconstrucción de la imagen rinde mejor en la RTX 3090 Ti a 2160p que a ninguna otra resolución.

‘Control’ es uno de los juegos que implementan ray tracing.

Por lo que nos ha ayudado a poner a prueba el rendimiento de las tarjetas cuando se enfrentan al trazado de rayos. Una vez más, a 1080p y 1440p la GeForce RTX 3090 Ti se ha visto superada por otras tarjetas gráficas, pero a 2160p se impone sin contemplaciones.

Un apunte importante: la técnica de reconstrucción de imagen (RI) utilizada por las tarjetas de NVIDIA es DLSS 2.x, mientras que en las Radeon RX hemos recurrido al algoritmo de reconstrucción desde una resolución inferior implementado en el motor del propio juego.

‘DiRT 5’ confirma lo que hemos observado en las pruebas anteriores: a 2160p la GeForce RTX 3090 Ti es intratable. Sin embargo, en este juego en particular esta tarjeta también ha superado a las demás soluciones gráficas con claridad a 1080p y 1440p.

En ‘Final Fantasy XV’ tenemos más de lo mismo. A 1080p y 1440p la GeForce RTX 3090 Ti no es la solución gráfica más rápida, pero a 2160p, una vez más, se siente como pez en el agua. Eso sí, con el motor gráfico de este juego la GeForce RTX 3080 Ti ha arrojado el mismo rendimiento a esta última resolución que su hermana mayor.

La jugada se repite. En ‘Rise of the Tomb Raider’.

Una vez más, la GeForce RTX 3090 Ti no es la tarjeta gráfica más rápida a 1080p y 1440p, pero es la que mejor rinde con claridad a 2160p. Poco más que añadir después de lo que hemos visto en los demás motores gráficos.

En la siguiente gráfica podemos ver que durante nuestras pruebas la GPU de la GeForce RTX 3090 Ti ha alcanzado la misma temperatura máxima que el procesador gráfico de la GeForce RTX 3080 Ti: 78 ºC. En cualquier caso, las nueve tarjetas gráficas trabajan bajo estrés en un rango de temperaturas muy razonable, lo que avala el sistema de refrigeración que han puesto a punto tanto los ingenieros de AMD como los de NVIDIA en sus diseños de referencia.

Para medir el nivel de ruido máximo emitido por cada tarjeta gráfica bajo estrés utilizamos nuestro sonómetro Velleman DVM805, y, como podéis ver en la siguiente gráfica, el nivel de ruido máximo emitido por la GeForce RTX 3090 Ti es ligeramente superior a la media. La solución gráfica más ruidosa de todas, y con cierta diferencia, es la Radeon RX 6900 XT, y la más silenciosa, también con cierta diferencia, es la más modesta GeForce RTX 3060 Ti.

Esta tarjeta gráfica es una auténtica bestia para creación de contenidos

Como acabamos de comprobar, este hardware gráfico de NVIDIA nos entrega un rendimiento excepcional cuando le pedimos que renderice las imágenes de cualquier videojuego a 2160p. Incluso al activar el trazado de rayos. Sin embargo, en este escenario de uso no podemos sacar partido a sus 24 GB de memoria de vídeo GDDR6X. De hecho, los ingenieros de NVIDIA no han integrado en esta tarjeta gráfica esta VRAM pensando en los juegos; lo han hecho con el propósito de optimizar su rendimiento con las aplicaciones de creación de contenidos.

Este descomunal frame buffer tiene el cometido de marcar la diferencia cuando los usuarios necesitamos utilizar esta tarjeta gráfica con motores de renderizado que trabajan con texturas de alta resolución, de modo que tanto la geometría de la escena como las texturas pueden almacenarse completas en la memoria de vídeo. De esta forma no es necesario recurrir a la memoria principal del PC para resolver el almacenamiento de estos objetos, una estrategia que permite al software de renderizado trabajar con tarjetas gráficas que tienen menos VRAM, pero que reduce el rendimiento del motor.

Otro escenario de uso en el que encajan como un guante los 24 GB GDDR6X que nos propone esta solución gráfica es la edición y el postprocesado de vídeo a 4K, y, sobre todo, a 8K. Cuando trabajamos con vídeo que tiene esta última resolución disponer de un mapa de VRAM tan amplio minimiza la probabilidad de que al recurrir a un efecto que ejerce un gran estrés sobre la GPU, como, por ejemplo, el reductor de ruido, la memoria local se llene y la aplicación de edición de vídeo acabe colapsando.

El descomunal ‘frame buffer’ de esta tarjeta gráfica marca la diferencia cuando necesitamos utilizarla con motores de renderizado que trabajan con texturas de alta resolución

Durante las semanas que hemos invertido en este análisis hemos sometido esta tarjeta gráfica a varios tests de renderizado y edición de vídeo en alta resolución, y sí, trabajar con ella es una delicia. Este es el escenario de uso en el que tiene sentido disponer de 24 GB de VRAM. La presencia de esta amplia memoria local tiene un impacto directo tanto en el rendimiento de la aplicación de creación de contenidos, que no se ve obligada a abordar algunas operaciones recurriendo a la memoria principal, como en nuestra experiencia gracias a que los errores provocados por no tener suficiente VRAM desaparecen de un plumazo.

NVIDIA GeForce RTX 3090 Ti: la opinión

Esta tarjeta gráfica impone. Lo hace por sus dimensiones, y también, lo que es mucho más importante, por su rendimiento. Nuestro banco de pruebas nos ha demostrado que es una solución diseñada para entregarnos todo su potencial a 2160p. En algunos juegos supera a las demás tarjetas gráficas que hemos analizado también a 1080p y 1440p, pero no cabe duda de que la resolución en la que mejor rinde y en la que impone su superioridad con mucha autoridad es a 2160p.

- Quien necesita una solución para crear y procesar contenidos con resolución 4K y 8K, además de para jugar a 2160p, acertará si elige esta tarjeta gráfica

- En cualquier caso, esta GeForce RTX 3090 Ti no es una tarjeta apropiada para un abanico amplio de jugadores. De hecho, a quien está buscando una solución gráfica únicamente para jugar a 2160p le recomendamos una GeForce RTX 3080 Ti o una Radeon RX 6900 XT. En este escenario de uso estas dos tarjetas gráficas nos parecen más interesantes porque tienen una relación precio/prestaciones más atractiva que esta GeForce RTX 3090 Ti.

Sin embargo, quien necesita una solución gráfica para crear y procesar contenidos con resolución 4K y 8K, además de para jugar a 2160p, acertará si elige la tarjeta gráfica que hemos puesto a prueba en este artículo. Como hemos comprobado, su memoria VRAM ha sido dimensionada para resolver con eficacia la creación de contenidos en alta resolución, por lo que tiene sentido pagar lo que NVIDIA nos pide por ella si realmente vamos a sacarle el máximo partido. En este escenario de uso mixto esta GeForce RTX 3090 Ti se impone a cualquier otro hardware gráfico con una rotundidad impactante.